2024-03-27

3月21日,AMD AI PC创新峰会在北京举行。作为AI PC元年全球半导体圈首场以此为主题的活动,AMD展示了自己与合作伙伴在AI PC领域取得的进展:现有30款新的AI PC产品;首次将NPU芯片集成在了台式机处理器中,其算力达到39TOPS;十多种全球和中国开源LLM在设备上运行,超过20个LLM的参数规模在20亿以上,最高达到720亿……

AMD董事会主席兼首席执行官苏姿丰现身峰会现场,并为面向下一代人工智能设备的计算引擎划定了战略重点。

在2个小时的活动上,不论是介绍企业战略的苏姿丰,还是介绍AMD技术路线的AMD GPU技术与工程研发高级副总裁David Wang(王启尚),都强调了一个词:合适。

苏姿丰在演讲中提到,当你看到我们的人工智能硬件产品组合和软件功能时,我们会讨论很多,关键是要为每个市场提供合适的解决方案。

“我们实际上更关注AI PC,这是一个全新的设备类别,我看到的是将PC转变为最智能和最个性化的设备的能力。”苏姿丰说道。

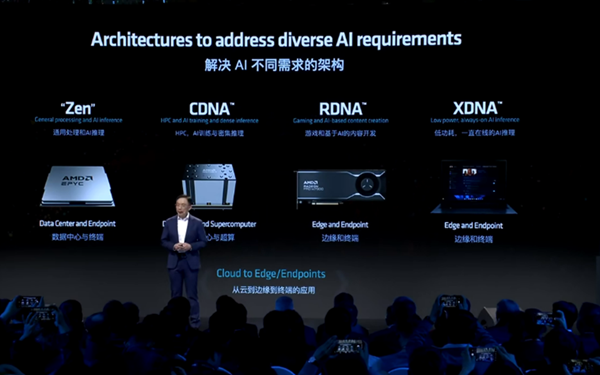

对于适合AI PC的处理器,David Wang对其再做分类:Zen、RDNA 、XDNA。他介绍,Zen架构主要是用于通用处理和AI推理,RDNA主要是用于游戏和基于AI的内容开发,而XDNA用于低功耗的AI推理。

David Wang介绍AMD解决AI的不同需求的架构

在针对上述三种架构的介绍中,用于NPU的XDNA架构给记者留下的印象最为深刻。David Wang介绍,XDNA的Adaptive dataflow(自适应数据流)架构解决了深层次AI面临的主要挑战:带宽有限、内存消耗大和高功耗。“我们通过自适应互联,将深度的神经网络映射到Custom dataflow(自定义数据流)上。这样就可以减少对于外部内存的访问,从而提高性能和能效。”David Wang介绍,“这就是XDNA能够在电池供应的AI PC上提供最佳AI性能的原因。”

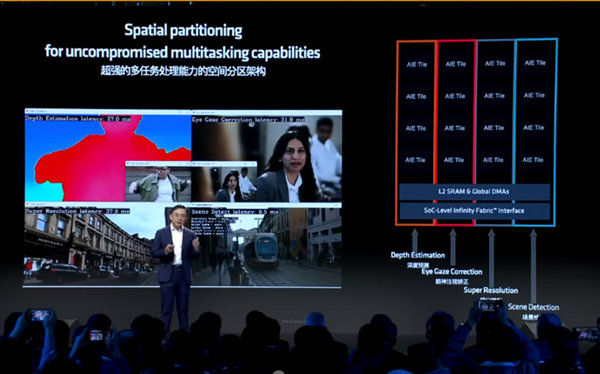

David Wang还介绍了XDNA架构的另外一个主要的优势——special partitioning(空间分区架构)。他说,该架构能够支持多重任务处理,而不会影响服务的品质。他在现场展示了一个案例:设备上同时执行了深度的预测、眼睛注视的矫正、超分辨率和场景的检测四个AI工作负载。每个空间分区执行一个负载,上述四个应用程序可在互不影响性能的情况下保持服务质量。

AMD XDNA具备空间分区架构

NPU的采用,还大大降低了CPU和GPU的工作负载。AMD现场展示了本地文生图、文生文、图生图几项生成式人工智能的应用。现场结果显示,上述几项应用执行过程中,CPU和GPU的负载极低,CPU负荷不超过8%。David Wang还介绍了Zen4和RDNA两个架构。Zen4采用了AVX-512指令集,以更节能的方式来加速AI推理。从而实现了Int8推理方面的性能提升85%。同时,Zen4还支持BF16,可提供两倍于FP32的性能,同时能够保持与FP32相同的动态范围 (BF16和FP32均为大模型的精度,分别为用16位二进制来表示的浮点数和用32位二进制来表示的浮点数)。这样让开发者能够很便捷地把FP32的模型转换成BF16的模型。

RDNA架构更适用于高性能游戏场景。相较于RDNA2,RDNA3将AI加速器的数量增加了一倍,提供了高达2.3倍的峰值AI性能提升。相比于RDNA2,RDNA3提供了超过1.5倍的每瓦性能和1.8倍的光追性能,使整体的游戏性能提升了1.4倍。

定义AI PC

AI PC该是什么样的?

大模型是诸多演讲人离不开的词。

在活动上,联想集团执行副总裁兼中国区总裁刘军阐释了AI PC的五大特征:一是内嵌基于个人大模型、自然交互的个人智能体,二是内嵌个人知识库,三是具备CPU+GPU+NPU的本地异构算力,四是连接开放的AI应用的系统生态,五是保护个人的隐私及数据安全。刘军补充道,内嵌在本地的个人大模型,不仅要具备在离线状态下完成工作任务的能力,还要更方便地与本地知识库集成,结合用户的风格生成个性化的作品。

刘军分享AI PC五大特征

David Wang表示,当前,大型闭源模型的规模呈指数级增长趋势。而较小的开源模型,特别是针对边缘和终端的专门任务的模型,也同样有效。他举例称,Llama 7B在简单的问答总结和翻译任务中表现得非常出色,相较于高等级版本可显著降低成本和能耗,并且在终端运行时,会提供更好的隐私和安全性。“通过更广泛的开发者社区的参与,开源模型还能实现更多的创新。”David Wang表示。

将开源模型用于AI PC,不只是AMD的考量。

始智AI CEO刘道全介绍了他们正在做的事情:建立开源基础模型开源社区,作为中立者,集中开源模型资源,连接处理器供应商、软件应用商等生态伙伴。之所以做开源社区的尝试,刘道全给出的理由是:“未来,尤其是在to B领域中,可能60%的大模型应用都会基于开源大模型来做。开源基础开源社区的建立就是为了发展模型与应用的生态。”

AMD中国AI生态合作伙伴共话AI PC应用可能

在活动现场,还有诸多中国ISV生态系统的代表,始智AI、百川智能、有道、游戏加加、生数与另外30多家ISV合作伙伴在会上展示了AMD AI PC体验。在体验区,记者看到了丰富多样的模型在PC端应用的实例:绘画、视频剪辑、代码撰写、音乐创作……与会嘉宾也谈了自己对AI PC应用的畅想。有道首席科学家段亦涛说,教育是需要个性化的行业。可以用算法,用模型针对学生的数据进行深度的分析,从而为每个学生量身打造个性化的学习路径。百川智能联席总裁洪涛说,端侧模型要具备三项能力,首先是性能要稳定,其次是要有强大的意图理解能力,第三是能够做任务规划,判断力足够强,在本地算力足够或有隐私性要求的情况下在本地生成结果,对于一些复杂的、需要大参数模型调用的,也能做云端的调用。

来源:中国电子报、电子信息产业网